En su momento abordamos tecnologías como el Deep Learning, la Realidad Virtual y Realidad Aumentada, por mencionar algunos conceptos con las que convivimos como usuarios y con las que muchos profesionales TI trabajan diariamente.

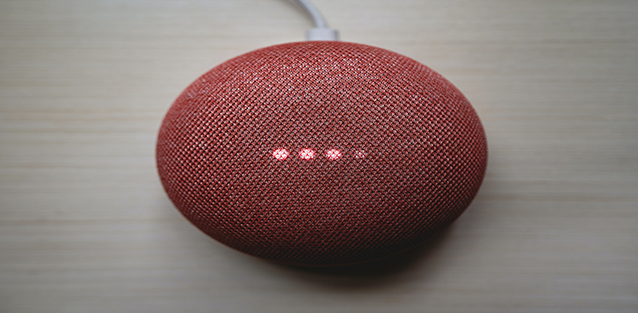

En esta ocasión es momento de conocer la historia del Natural Language Processing (NLP) o Procesamiento natural del lenguaje. Una tecnología que muy cercana y conocida gracias a Siri y Alexa.

Antes de pasar a su historia, veremos un concepto general del NLP, que se trata de una forma de inteligencia artificial (IA) que brinda a las computadoras la capacidad de leer, comprender e interpretar el lenguaje humano.

El NLP ayuda a las computadoras a medir el sentimiento y determinar qué partes del lenguaje humano son importantes. Para las computadoras, esto es algo extremadamente difícil de hacer debido a la gran cantidad de datos no estructurados, la falta de reglas formales y la ausencia de un contexto o intención del mundo real.

Como mencionamos, el lenguaje humano es extremadamente complejo y diverso. Es por eso que el Procesamiento del Lenguaje Natural incluye muchas técnicas para interpretarlo, que van desde métodos estadísticos y de Machine Learning hasta enfoques algorítmicos y basados en reglas. Hay cinco tareas básicas de NLP que se deben tener presente:

- Parte del etiquetado de voz

Una de las tareas de la NLP es el etiquetado de voz. Para cada oración, se determina la parte del discurso de cada palabra. Parte del habla es una categoría de palabras que tienen propiedades gramaticales similares. Por ejemplo, la palabra libro es un sustantivo en la oración el libro sobre la mesa, pero es un verbo en la oración para reservar un vuelo. Y una palabra como conjunto puede ser incluso un sustantivo, un verbo o un adjetivo.

Existe una gran cantidad de palabras que pueden servir como múltiples partes del discurso, lo que dificulta que una máquina les asigne las etiquetas correctas.

La lematización se refiere a eliminar sólo las terminaciones flexivas y reducir una palabra a su forma básica, que también se conoce como «lema». Los tiempos pasados se cambian a presente y los sinónimos se unifican.

La lematización utiliza un enfoque diferente a la derivación para llegar a la forma raíz de una palabra.

La tarea de tokenización es cortar un texto en partes más pequeñas llamadas tokens. Este proceso segmenta un fragmento de texto continuo en oraciones y palabras separadas, mientras que al mismo tiempo elimina ciertos caracteres, como la puntuación.

- Desambiguación

La desambiguación es una tarea que tiene que ver con el significado de las palabras que usamos en el lenguaje humano. Algunas palabras tienen más de un significado, y mientras leemos, seleccionamos el significado que tiene más sentido en el contexto dado.

- Semántica

Los seres humanos se comunican según el significado y el contexto. La semántica ayuda a las computadoras a identificar la estructura de las oraciones y los elementos más relevantes de un texto para comprender el tema que se discute.

Historia del Procesamiento del Lenguaje Natural

La idea que impulsó la imaginación de investigadores y entusiastas de la Inteligencia Artificial nos llevan a Alan Turing como punto de partida. Aunque limitado por su época no vería concretadas muchas de estas tecnologías.

Así que pasemos hasta ciertos momentos que están relacionados al desarrollo del PNL. Esto inicia en 1958, cuando John McCarthy lanzó el lenguaje de programación LISP. En 1964, se desarrolló ELIZA, un proceso de comentario y respuesta “mecanografiado”, diseñado para imitar a un psiquiatra utilizando técnicas de reflexión. (Lo hizo reorganizando oraciones y siguiendo reglas gramaticales relativamente simples, pero no hubo comprensión por parte de la computadora). También en 1964, el Consejo Nacional de Investigación de EE. UU. (NRC) creó el Comité Asesor de Procesamiento Automático del Lenguaje, o ALPAC, para abreviar . Este comité se encargó de evaluar el progreso de la investigación sobre el procesamiento del lenguaje natural.

En 1966, la NRC y ALPAC iniciaron la primera interrupción de la IA y la PNL, al detener la financiación de la investigación sobre el procesamiento del lenguaje natural y la traducción automática. Después de doce años de investigación y 20 millones de dólares, las traducciones automáticas seguían siendo más caras que las traducciones humanas manuales, y todavía no había computadoras que se acercaran a poder mantener una conversación básica. En 1966, muchos consideraban que la investigación sobre inteligencia artificial y procesamiento del lenguaje natural (PNL) era un callejón sin salida.

Fueron necesarios casi catorce años, hasta 1980, para que la investigación de Procesos de lenguaje natural e Inteligencia artificial se recuperara de las expectativas rotas creadas por los entusiastas. De alguna manera, el paro de la IA había iniciado una nueva fase de nuevas ideas, con el abandono de los conceptos anteriores de traducción automática y las nuevas ideas que promovían nuevas investigaciones, incluidos los sistemas expertos. La combinación de lingüística y estadística, que había sido popular en las primeras investigaciones de la PNL, fue reemplazada por un tema de pura estadística.

A finales de la década de 1980, se produjo una revolución en la PNL. Este fue el resultado tanto del aumento constante de la potencia computacional como del cambio a los algoritmos de Machine Learning. Si bien algunos de los primeros algoritmos de ML produjeron sistemas similares a las reglas escritas a mano de la vieja escuela, la investigación se centró cada vez más en los modelos estadísticos. Estos modelos estadísticos son capaces de tomar decisiones probabilísticas suaves.

En la década de 1990, la popularidad de los modelos estadísticos para los análisis de Procesos de Lennguaje Natural aumentó drásticamente. Los métodos puramente estadísticos de PNL se volvieron muy valiosos para mantener el ritmo del enorme flujo de texto en línea. Los N-Grams se volvieron útiles, reconociendo y rastreando grupos de datos lingüísticos, numéricamente. En 1997, se introdujeron los modelos de red neuronal recurrente LSTM (RNN) y encontraron su nicho en 2007 para el procesamiento de voz y texto. Actualmente, los modelos de redes neuronales se consideran la vanguardia de la investigación y el desarrollo en la comprensión de la PNL de la generación de texto y voz.

En el año 2011, Siri de Apple se hizo conocido como uno de los primeros asistentes exitosos de PNL / IA del mundo para ser utilizado por los consumidores en general. Dentro de Siri, el módulo de reconocimiento de voz automatizado traduce las palabras del propietario en conceptos interpretados digitalmente. El sistema de Comando de Voz luego hace coincidir esos conceptos con los comandos predefinidos, iniciando acciones específicas.

Al utilizar técnicas de Machine Learning, el patrón de habla del propietario no tiene que coincidir exactamente con expresiones predefinidas. Los sonidos solo tienen que ser razonablemente cercanos para que un sistema de PNL traduzca el significado correctamente. Mediante el uso de un circuito de retroalimentación, los motores de PNL pueden mejorar significativamente la precisión de sus traducciones y aumentar el vocabulario del sistema.

La combinación de un administrador de diálogo con la PNL hace posible desarrollar un sistema capaz de mantener una conversación y sonar como un humano, con preguntas, indicaciones y respuestas de ida y vuelta. Nuestras IA modernas, sin embargo, todavía no pueden pasar la prueba de Alan Turing, y actualmente no suenan como seres humanos reales.

imagen: Clay Banks